Result Assessment Tool (RAT)

Das Gesamtziel des Projekts besteht darin, das Result Assessment Tool (RAT) weiterzuentwickeln und zu verbessern, so dass es zu einem stabilen, flexiblen und nachhaltigen Instrument für die Durchführung von Studien wird, die sich mit der Sammlung und Analyse von Daten aus Suchmaschinen und anderen Information Retrieval Systemen befassen. Das Result Assessment Tool (RAT) ist ein Software-Toolkit, das es Forschern ermöglicht, groß angelegte Studien auf der Grundlage von Ergebnissen aus (kommerziellen) Suchmaschinen und anderen Information Retrieval Systemen durchzuführen. Es besteht aus Modulen für (1) den Entwurf von Studien, (2) die Sammlung von Daten aus Suchsystemen, (3) die Sammlung von Urteilen über die Ergebnisse, (4) das Herunterladen/Analysieren der Ergebnisse.

Erkenntnisse

Durch die Modularität können einzelne Komponenten für eine Vielzahl von Studien zu Webinhalten, wie z.B. qualitative Inhaltsanalysen, eingesetzt werden. Durch automatisiertes Scraping können Webdokumente in empirischen Studien quantitativ ausgewertet werden.

Nachhaltigkeit

Wir werden die Nachhaltigkeit der Projektergebnisse durch Maßnahmen in drei Bereichen sicherstellen: (1) Einführung und Verbreitung der Software, (2) Aufbau und Pflege einer Nutzer- und Entwicklergemeinschaft, (3) Veröffentlichung der Software als Open Source.

Software

Die modulare webbasierte Software kann automatisch Daten aus Suchmaschinen erfassen. Studien mit Fragen und Skalen lassen sich flexibel gestalten, und die Informationsobjekte können von Juroren anhand der Fragen bewertet werden.

Result Assessment Tool (RAT)

Ein Ausgangspunkt für die Entwicklung vom RAT war die Tatsache, dass Studien zur Effektivität des Retrievals in der Regel viel manuelle Arbeit bei der Konzeption des Tests, der Erfassung der Suchergebnisse, der Suche nach Juroren und der Erfassung ihrer Bewertungen sowie bei der Analyse der Testergebnisse erfordern. RAT setzt an all diesen Punkten an und soll helfen, Retrieval-Studien effizienter und effektiver zu gestalten.

The design of the RAT prototype has been guided by the requirement of researchers to query external information retrieval systems in general, and search engines in particular. This need derives from researchers’ interest in the quality of their search results, the composition of their results (lists or pages), and potential biases in the results, to name but a few. This is a unique approach that separates RAT from software developed to aid retrieval evaluation where researchers have complete control over the systems evaluated.

RAT ermöglicht die Durchführung von Studien im Rahmen der beiden wichtigsten Evaluierungsparadigmen, nämlich der systemzentrierten und der nutzerzentrierten Evaluierung.

Darüber hinaus ist RAT auch für andere Forscher*innen nützlich, die Ergebnisse von Suchmaschinen für weitere Analysen nutzen möchten. Während der Grundgedanke von RAT in der Bewertung von Information Retrieval liegt, geht sein Einsatz weit über dieses Forschungsgebiet hinaus. Bereits in der Prototypenphase haben wir festgestellt, dass es einen erheblichen Bedarf an einem Software-Tool wie RAT in den Suchmaschinen- und Information-Retrieval-Communities gibt. Einige Projekte haben dies bereits demonstriert.

Use the demo version at http://rat-software.org/home

RAT Community-Meeting 2023

Das erste RAT-Community-Meeting brachte Forschende zusammen, die an der Nutzung von Suchmaschinendaten in ihrer Forschung interessiert sind.

Highlights des Programms waren:

- Showcases: Erfahren Sie, wie Forschende das RAT eingesetzt haben, um eine Vielzahl von Themen wie Klimawandel, Fake News, Gesundheitsthemen und vieles mehr zu untersuchen.

- Tutorials: Erfahren Sie, wie Sie dieses leistungsstarke Instrument in Ihrer Forschung effektiv einsetzen können - von der Datenerfassung bis hin zur Analyse.

- Poster-Session: Erfahren Sie, wie das RAT in verschiedenen Forschungsprojekten eingesetzt wurde und wie die Funktionalität von RAT durch Add-ons erweitert wurde.

Showcases and extensions

Welcome

Dirk Lewandowski

University of Duisburg-Essen, Hamburg University of Applied Sciences

The Query Sampler

Nurce Yagci,

Hochschule für Angewandte Wissenschaften Hamburg

The SEO Classifier

Sebastian Sünkler;

Hochschule für Angewandte Wissenschaften Hamburg

Rammstein Debate

Sebastian Sünkler,

Hochschule für Angewandte Wissenschaften Hamburg

Greyzone Medicines

Olof Sundin, Kristofer Söderström, Lund University

Mapping politics of exclusion

Ov Cristian Norocel, Lund University

Political candidates and SEO

Kay Hinz,

Agrus Data Insights

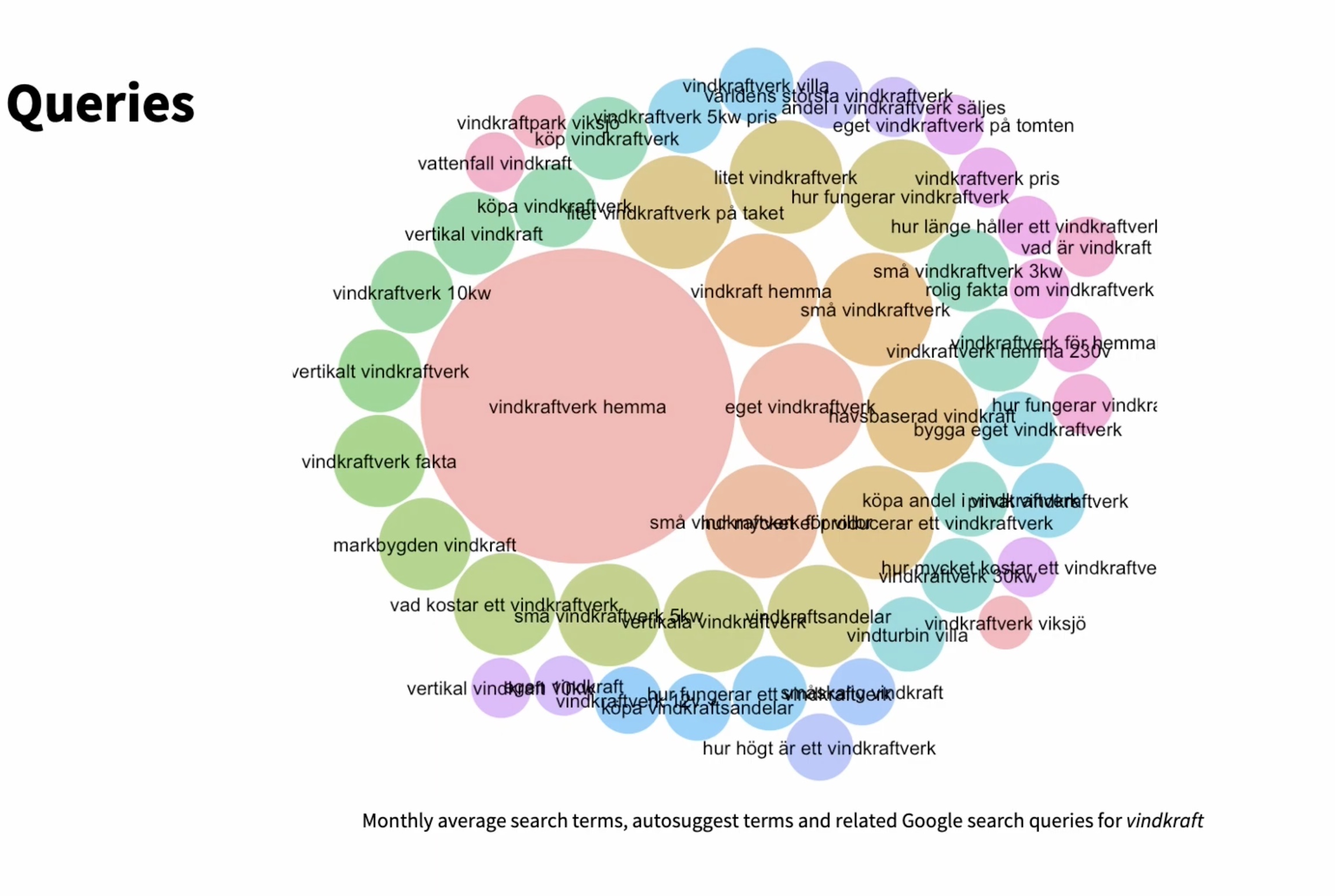

Understanding wind power

Björn Ekström,

Swedish School of Library and Information Science,

University of Borås

Poster-Session

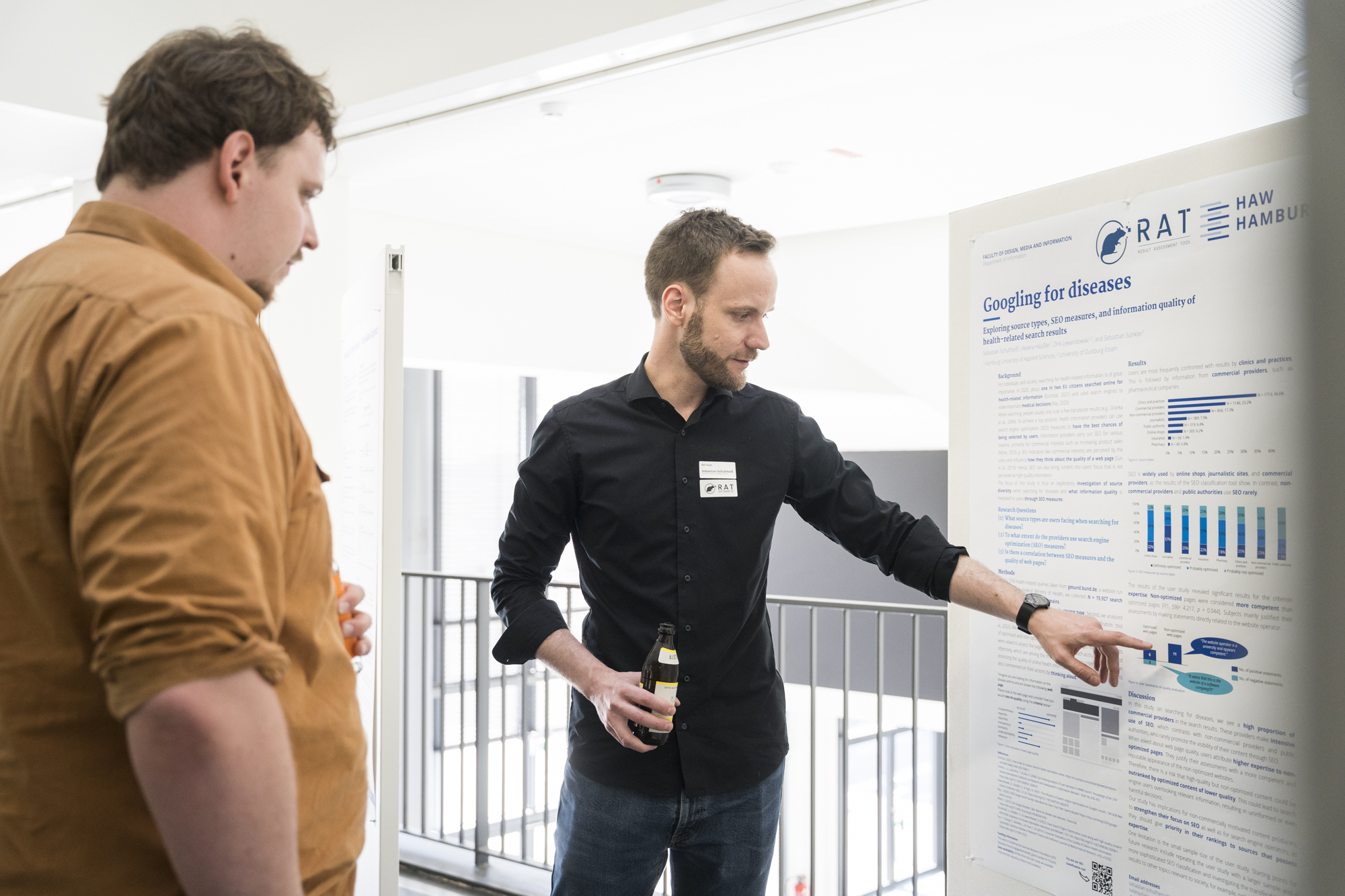

Googling for diseases

Sebastian Schultheiß,

Hochschule für Angewandte Wissenschaften Hamburg

EI-Logger Plug-In

Hossam Al Mustafa,

University of Duisburg-Essen

Comparison of Climate Related Results

Tuhina Kumar,

University of Duisburg-Essen

Readability of Web Documents

Mohamed Elnaggar,

University of Duisburg-Essen

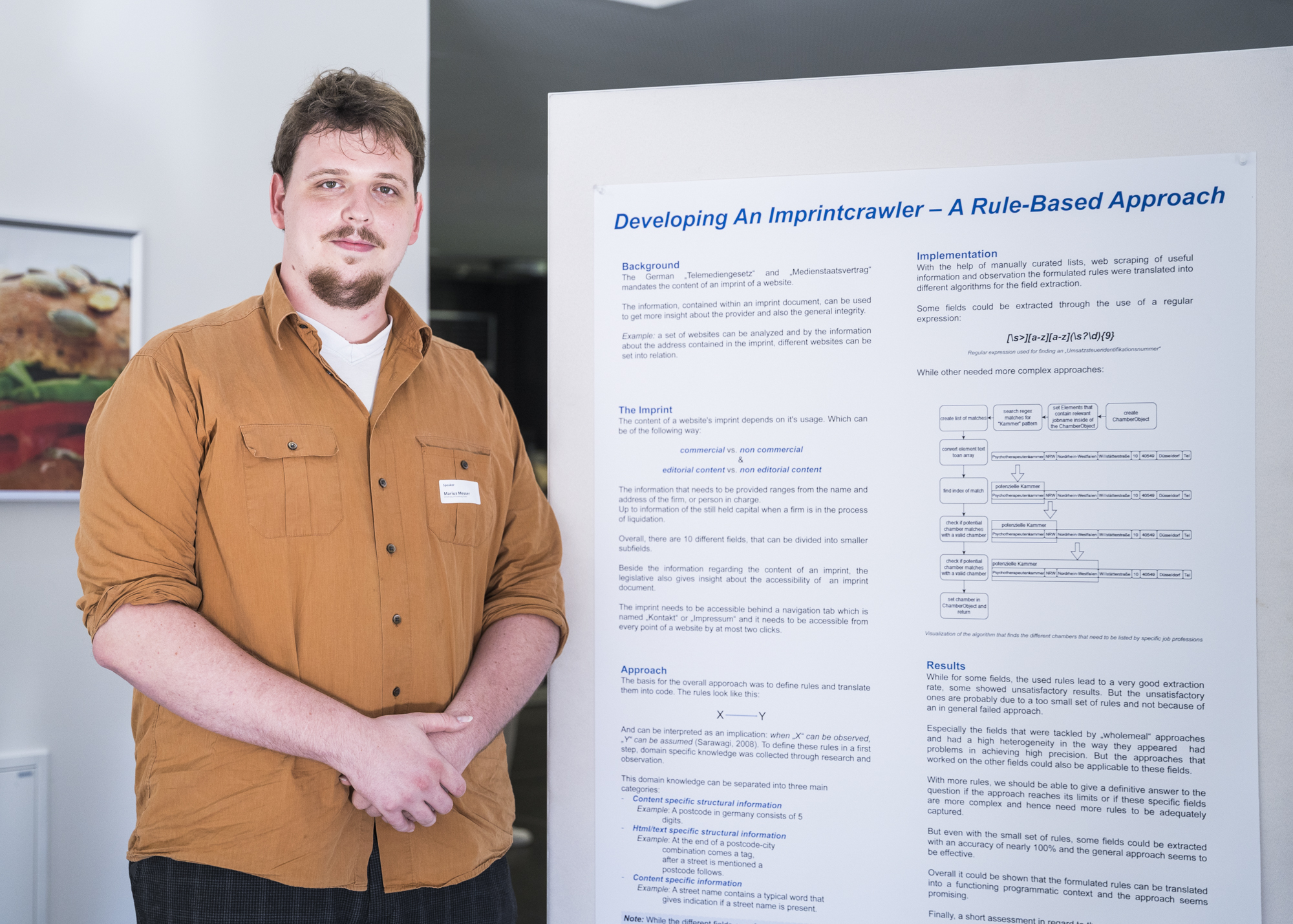

Imprint Crawler

Marius Messer,

University of Duisburg-Essen

Insurance offerings on Google

Sebastian Sünkler,

Hochschule für Angewandte Wissenschaften Hamburg

Automated web page classification

Nurce Yagci,

Hochschule für Angewandte Wissenschaften Hamburg

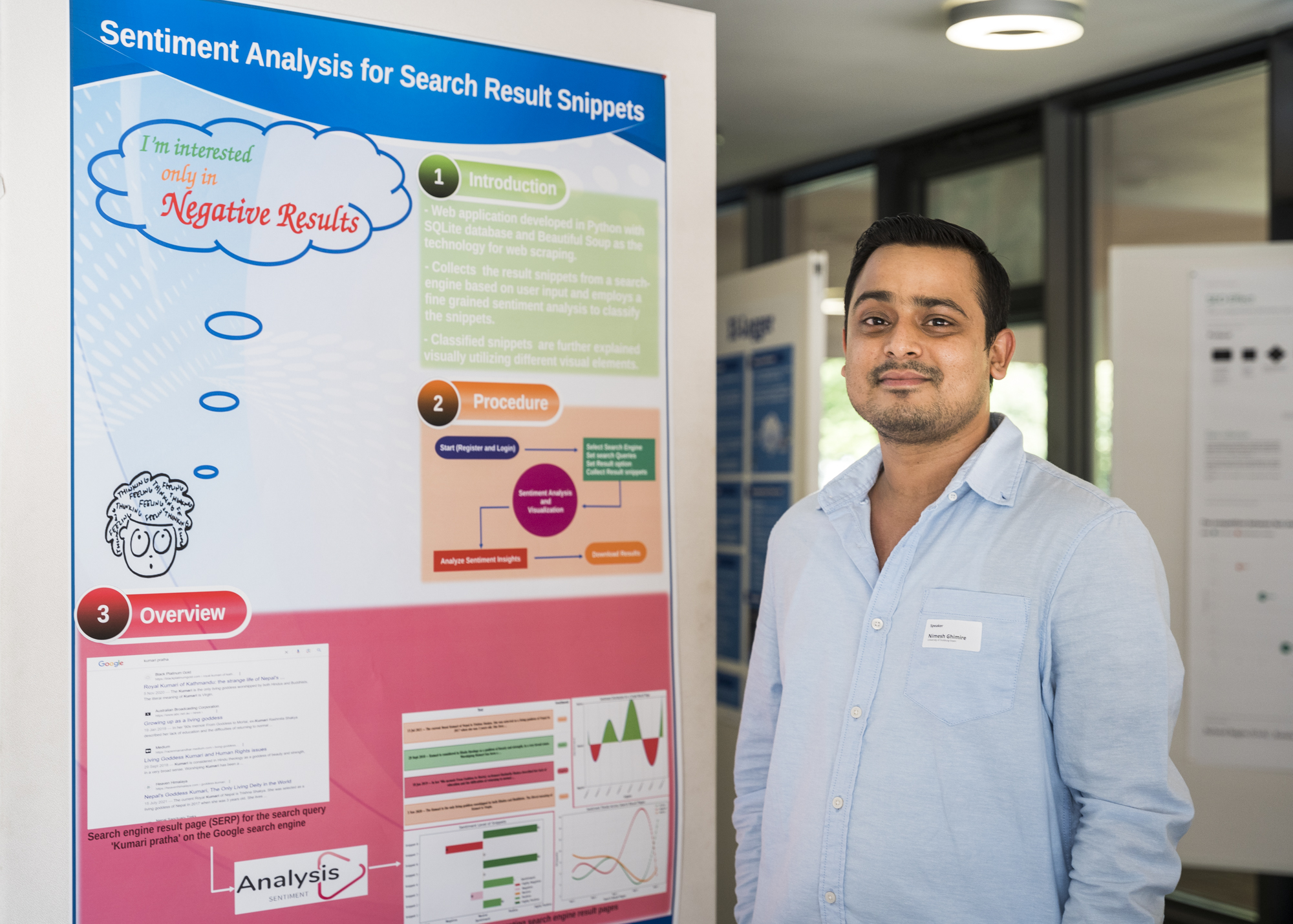

Sentiment analysis

Nimesh Ghimire,

University of Duisburg-Essen

Fact checks and ‘fake news’ in Google results

Kamila Koronska,

University of Amsterdam and AFP

Source Distribution

Helena Häußler,

Hamburg University of Applied Science

- “EI-Logger Plug-In: Explicit and implicit Logger for elicitation of search engine user’s data“, Hossam Al Mustafa, University of Duisburg-Essen

- “Measuring the Readability of Web Documents“, Mohamed Elnaggar, University of Duisburg-Essen

- “Sentiment analysis for search result snippets“, Nimesh Ghimire, University of Duisburg-Essen

- “A Comparison of Source Distribution and Result Overlap in Web Search Engines“, Helena Häußler, Hamburg University of Applied Sciences

- “A forum scraper for the Result Assessment Tool (RAT)", Paul Kirch, University of Duisburg-Essen

- “The competition between fact checks and ‘fake news’ in Google results“, Kamila Koronska, University of Amsterdam and AFP

- “Comparison of Results Shown by Different Search Engines for Climate-Related Topics“, Tuhina Kumar, University of Duisburg-Essen

- “Imprint crawler – a web crawler specialized in the automatic imprint extraction of websites under consideration of the German Legislation“, Marius Messer, University of Duisburg-Essen

- “Googling for diseases: Exploring source types, SEO measures, and information quality of health-related search results“, Sebastian Schultheiß, Hamburg University of Applied Sciences

- “What does Google recommend when you want to compare insurance offerings? – A study investigating source distribution in Google’s top search results“, Sebastian Sünkler, Hamburg University of Applied Sciences

- “Automated web page classification: A systematic literature review“, Nurce Yagci, Hamburg University of Applied Sciences

Publikationen

Schultheiß, S.; Lewandowski, D.; von Mach, S.; Yagci, N. (2023). Query sampler: generating query sets for analyzing search engines using keyword research tools. In: PeerJ Computer Science 9(e1421). http://doi.org/10.7717/peerj-cs.1421

Lewandowski, D., & Sünkler, S. (2019). Das Relevance Assessment Tool. Eine modulare Software zur Unterstützung bei der Durchführung vielfältiger Studien mit Suchmaschinen. In: Information – Wissenschaft & Praxis 70 (1), 46-56. https://doi.org/10.1515/iwp-2019-0007

Lewandowski, Dirk; Sünkler, Sebastian: Relevance Assessment Tool: Ein Werkzeug zum Design von Retrievaltests sowie zur weitgehend automatisierten Erfassung, Aufbereitung und Auswertung der Daten. In: Proceedings der 2. DGI-Konferenz: Social Media und Web Science – Das Web als Lebensraum. Frankfurt am Main: DGI, 2012, S. 237-249.

Lewandowski, D.; Sünkler, S.: Designing search engine retrieval effectiveness tests with RAT. Information Services & Use 33(1), 53-59, 2013. https://doi.org/10.3233/ISU-130691

Vorträge

Sünkler S.; Yagci, N.; Schultheiß, S.; von Mach, S.; Lewandowski, D.; (2024) Result Assessment Tool Software to Support Studies Based on Data from Search Engines In: Part of the book series: Lecture Notes in Computer Science https://link.springer.com/chapter/10.1007/978-3-031-56069-9_19

Sünkler, S.; Yagci, N.; Sygulla, D.; von Mach, S.; Schultheiß, S., Lewandowski, D.; (2023). Result Assessment Tool (RAT): A Software Toolkit for Conducting Studies Based on Search Results. In: Proceedings of the Association for Information Science and Technology https://doi.org/10.1002/pra2.972

Schultheiß, S.; Sünkler, S.; Yagci, N.; Sygulla, D.; von Mach, S.; Lewandowski, D.; (2023). Simplify your Search Engine Research : wie das Result Assessment Tool (RAT) Studien auf der Basis von Suchergebnissen unterstützt. In: Proceedings des 17. Internationalen Symposiums für Informationswissenschaft (ISI 2023), 429-437. PDF proceedings; PDF article

Sünkler, S.; Yagci, N.; Sygulla, D.; von Mach, S.; Schultheiß, S.; Lewandowski, D.; (2023). Result Assessment Tool (RAT): Software-Toolkit für die Durchführung von Studien auf der Grundlage von Suchergebnissen. In: Proceedings des 17. Internationalen Symposiums für Informationswissenschaft (ISI 2023), 438-444. PDF proceedings ; PDF article

Sünkler, S., Yagci, N., Sygulla, D., von Mach, S., Schultheiß, S. Lewandowski, D. (2022). Result Assessment Tool (RAT). Informationswissenschaft im Wandel. Wissenschaftliche Tagung 2022 (IWWT22), Düsseldorf. PDF proceedings; PDF article

Forschung, die mit Hilfe des RAT durchgeführt wurde (Auswahl)

Ekström, B., & Tattersall Wallin, E. (2023). Simple questions for complex matters?: An enquiry into Swedish Google search queries on wind power. Nordic Journal of Library and Information Studies, 4(1), 34–50. https://doi.org/10.7146/njlis.v4i1.136246

Norocel, O.C.; Lewandowski, D. (2023):. Google, data voids, and the dynamics of the politics of exclusion. In: Big Data & Society. https://doi.org/10.1177/205395172211490

Haider, J.; Ekström, B.: Tattersall Wallin, E.; Gunnarsson Lorentzen, D.; Rödl, M.; Söderberg, N. (2023). Tracing online information aboutwind power in Sweden: An exploratory quantitative study of broader trends. https://www.diva-portal.org/smash/get/diva2:1740876/FULLTEXT01.pdf

Sünkler, S.; Lewandowski, D.: Does it matter which search engine is used? A user study using post-task relevance judgments. In: Proceedings of the 80th Annual Meeting of the Association of Information Science and Technology, Crystal City, VA, USA. https://doi.org/10.1002/pra2.2017.14505401044

Schaer, P.; Mayr, P.; Sünkler, S.; Lewandowski, D.: How Relevant is the Long Tail? A Relevance Assessment Study on Million Short. In: N. Fuhr et al. (eds.): Experimental IR Meets Multilinguality, Multimodality, and Interaction (Lecture Notes in Computer Science, Vol. 9822), pp. 227-233. https://doi.org/10.1007/978-3-319-44564-9_20

Behnert, C.: LibRank: New Approaches for Relevance Ranking in Library Information Systems. In: Pehar, F.; Schlögl, C.; Wolff, C. (eds.): Re:inventing Information Science in the Networked Society. Proceedings of the 14th International Symposium on Information Science (ISI 2015). Glückstadt: Verlag Werner Hülsbusch, 2015. S. 570-572

Lewandowski, D.: Evaluating the retrieval effectiveness of web search engines using a representative query sample. In: Journal of the American Society for Information Science and Technology (JASIST) Vol. 66 (2015) Nr. 9, p. 1763 – 1775. https://doi.org/10.1002/asi.23304

Lewandowski, D.: Verwendung von Skalenbewertungen in der Evaluierung von Web-Suchmaschinen. In: Hobohm, H.-C. (Hrsg.): Informationswissenschaft zwischen virtueller Infrastruktur und materiellen Lebenswelten. Proceedings des 13. Internationalen Symposiums für Informationswissenschaft (ISI 2013). Boizenburg: Verlag Werner Hülsbusch, 2013. S. 339-348.

Working papers

Sünkler, S. & Yagci, N. (2023). Technical documentation of the Result Assessment Tool. Working paper. https://doi.org/10.17605/OSF.IO/3Z4DF

Schultheiß, S. & Lewandowski, D. (2023). Evaluating the usability of the Result Assessment Tool (RAT) using User-centered design (UCD) principles. Working paper. https://doi.org/10.17605/OSF.IO/V4QT9

Studentische Arbeiten

2022. Studentische Arbeit zu Verzerrungen in Bibliothekskatalogen. [Research project]

Günther, Markus, 2016. Welches Weltbild vermitteln Suchmaschinen? Untersuchung der Gewichtung inhaltlicher Aspekte von Google- und Bing-Ergebnissen in Deutschland und den USA zu aktuellen internationalen Themen. [Masterarbeit]

Stempel, Anne, 2016. Suchverhalten in Internet Suchmaschinen – Analyse der Unterschiede in den Suchanfragen von Senioren im Vergleich zu Teenagern. [Bachelorarbeit]

Podgajnik, Lea, 2013. Relevanzanalyse niedrig gerankter Google-Suchergebnisse auf informationsorientierte Suchanfragen mit dem Relevance Assessment Tool. [Bachelorarbeit]

Gather, Alexandra, 2013. Suchmaschinen und Sprache : eine Studie über den Umgang von Google und BING mit den Besonderheiten der deutschen Sprache. [Masterarbeit]

Günther, Markus, 2012. Evaluierung von Suchmaschinen : Qualitätsvergleich von Google- und Bing-Suchergebnissen unter besonderer Berücksichtigung von Universal-Search-Resultaten. [Bachelorarbeit]

Sünkler, Sebastian, 2012. Prototypische Entwicklung einer Software für die Erfassung und Analyse explorativer Suchen in Verbindung mit Tests zur Retrievaleffektivität. [Masterarbeit]

Projektteam

Sebastian Sünkler

Dirk Lewandowski

Tuhina Kumar

Sebastian Schultheiß

Nurce Yagci

Daniela Sygulla

Sonja von Mach

Gefördert von der Deutschen Forschungsgemeinschaft (DFG):

Funding period: 08/2021 - 07/2024, grant number 460676551.